Im Juli 2014 haben Arvind Narayanan (@random_walker) und Edward Felten (@EdFelten) (beide Princeton University) ein Paper mit dem Titel „No silver bullet: De-identification still doesn’t work“ veröffentlicht, das im Wesentlichen eine Replik auf ein Paper von Cavoukian/Castro (Big Data and Innovation, Setting the Record Straight: Deidentification Does Work) darstellt. Cavoukian und Castro hatten in ihrem Paper im Kern dargestellt, dass es wirksame Techniken gibt, die eine Anonymisierung von Datensätzen ermöglichen. Narayanan und Felten wenden sich sehr überzeugend gegen diese Theorie.

1. Hintergrund

Zunächst kurz zum Hintergrund:

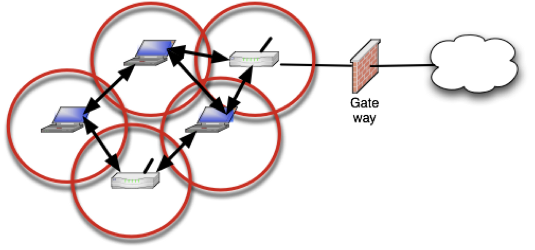

Wir befinden uns vermutlich noch am Anfang des Big Data-Zeitalters. Über jede einzelne Person werden immer mehr und immer genauere Daten erhoben und gespeichert (näher z.B. Kurz/Rieger, Die Datenfresser, 2012). Wer sich die Daten von/über Malte Spitz ansieht, die im Zuge der Kritik an der (deutschen und europäischen) Vorratsdatenspeicherung erhoben wurden, erhält eine leichte Idee davon. Man stelle sich zusätzlich vor, dass auch alle anderen Tätigkeiten von uns digital erfasst werden. Wenn sich alle diese Daten zusammenführen ließen und dann auch noch jeweils einer einzelnen Person zugeordnet werden kann, entsteht ein sehr genaues Bild über diese eine Person. Diesen Zustand soll unser Datenschutzrecht verhindern bzw. die Kontrolle über den Vorgang zumindest teilweise der jeweiligen Person erhalten.

Sollen nun Daten ohne konkrete Einwilligung oder gesetzlichen Erlaubnistatbestand erhoben und genutzt werden, bleibt dem Verarbeitungswilligen nur die Variante, die Daten dem Schutz des Datenschutzrechts vollständig zu entziehen. Das ist – möchte man meinen – eigentlich ganz einfach: Die Daten müssen ja „einfach nur“ anonymisiert werden. Wie das geht, sagt uns (in der Theorie) z.B. § 3 Abs. 6 BDSG:

Anonymisieren ist das Verändern personenbezogener Daten derart, dass die Einzelangaben über persönliche oder sachliche Verhältnisse nicht mehr oder nur mit einem unverhältnismäßig großen Aufwand an Zeit, Kosten und Arbeitskraft einer bestimmten oder bestimmbaren natürlichen Person zugeordnet werden können.

Es gibt eine Menge Literatur dazu (s. nur Simitis-Scholz, BDSG, 8. Aufl. 2014, § 3 Rn. 205 ff.), wie § 3 Abs. 6 BDSG zu verstehen ist. In dieser wird u.a. darauf hingewiesen, dass man klar zwischen Anonymisierung und Pseudonymisierung unterscheiden muss. Und Daten, die – wie es hier Narayanan und Felten darstellen de-anonymisiert werden können, sind schlicht nur pseudonymisierte und damit personenbezogene Daten.

2. Broken Promises of Privacy

Im Jahr 2009 hat Paul Ohm (@paulohm) in einem denkwürdigen Aufsatz namens „Broken promises of privacy: Responding to the surprising failure of anonymization” dargestellt, dass sich (eigentlich anonymisierte) Daten immer häufiger “de-anonymisieren” lassen – und zwar ohne so erheblichen Aufwand, dass von einer effektiven Anonymisierung nach § 3 Abs. 6 BDSG gesprochen werden kann. Die Frage und Möglichkeit der De-Anonymisierung ist daher eine tatsächliche Frage, die unmittelbar erhebliche rechtliche Konsequenzen nach sich zieht.

Vermutlich weil ein großes Interesse daran besteht, mit solche „anonymisierten“ Daten weiter zu arbeiten, gibt es auch Stimmen, die die Effektivität der Anonymisierung bzw. die Ineffektivität von Angriffen hiergegen hervorheben – wie z.B. den von Narayanan und Felten kritisierten Aufsatz von Cavoukian und Castro.

Narayanan und Felten zeigen in ihrem Aufsatz nun eindrucksvoll auf, dass die Ergebnisse von Cavoukian und Castro nicht nur auf Sand gebaut, sondern vermutlich einfach schlicht falsch sind. Hier nur ein paar Zitate aus dem Paper:

Let’s be clear about why the authors of the study didn’t actually re-identify anyone: because they didn’t set out to. …

The [Netflix]-study shows in detail that if someone knows just a little bit about the movie preferences of a user in the Netflix dataset (say, from Facebook or a water-cooler conversation), there’s an upwards of 80% chance of identifying that user’s record in the dataset. …

They mostly ignore the possibility of re-identification by a spouse, friend, nosey neighbor, or investigator based on specific knowledge about the victim, as well as a data-broker applying re-identification based on their existing datasets to enrich their dossiers …

The authors claim that data brokers’ databases “are often incomplete, making it difficult to positively identify someone with a high degree of confidence.” This is cold comfort to a person who is re-identified because they do appear in the database. And it doesn’t consider that a realistic adversary often can just buy access to another database if the first one doesn’t meet their needs. …

It is very tempting to look for an assurance that (say) only 1% of individuals in a dataset can be re-identified. But there is simply no scientific basis for interpreting re-identification probabilities of de-identified high-dimensional datasets as anything more than (weak) lower bounds, and we urge the reader to be wary of false promises of security.

Was kann man also Personen und Unternehmen, die große Datenmengen erheben, nutzen und weitergeben möchten, raten? Die einzig (noch?) effektive Methode scheint eine Aggregation von Daten: Wenn Daten so zusammengewürfelt werden, dass sie immer eine Gruppe von Personen betreffen, entzieht sie des Personenbezugs. Allerdings darf die Gruppe nicht zu klein geraten – und dadurch wird natürlich die Nützlichkeit der Daten stark eingeschränkt (s. näher zu Anonymisierungstechniken Simitis-Scholz, BDSG, 8. Aufl. 2014, § 3 Rn. 205 ff.). Sehr interessant fand ich in diesem Zusammenhang, dass Narayanan und Felten auch zeigen, dass die Technik , die bisher als halbwegs effektiv angesehen wurde, nämlich die Veränderung von Daten, so dass sie ungenauer werden (z.B. statt eines Datums nur das Jahr) angesichts der zunehmenden Datenmengen von Angreifern ebenfalls versagt.

Indeed, a key finding of the de Montjoye et al. study is that the main technique one might hope to use — making the data more coarse-grained — has only a minimal impact on uniqueness. …

… making the adversary’s auxiliary dataset more specific has the equal and opposite impact! Of course, with high-dimensional datasets, there are strong limits to how much the data can be generalized without destroying utility, whereas auxiliary information has the tendency to get more specific, accurate, and complete with each passing year.

Wer sich mit Anonymisierungstechniken beschäftigt und selbst Daten anonymisieren möchte, oder mit anonymisierten Daten arbeiten will (oder jemanden berät, der das tut), sollte sich im Übrigen darüber klar sein, dass es (rechtlich) völlig unbeachtlich ist, ob sich nur ein kleiner Teil der Daten einer bestimmten Person zuordnen lässt. Denn für jeden einzelnen dieser Fälle liegt aller Voraussicht nach eine unzulässige Datenverarbeitung vor. Dementsprechend kann man eigentlich nur empfehlen, „anonymisierte“ Daten, bei denen man nicht ganz und absolut sicher ist, ob sie wirklich anonym sind, als personenbezogene Daten zu behandeln.

3. Fazit

Obwohl der Aufsatz von Narayanan und Felten nur eine „Replik“ darstellt, ist er absolut lesenswert. Er enthält zudem eine Reihe von weiterführenden Links und Hinweisen. Es empfieht sich auch, das Paper von Cavoukian und Castro zu lesen. Im Übrigen hat auch Cory Doctorow die Diskussion zusammengefasst.

(Bild: Chris Hartman – CC BY 2.0)